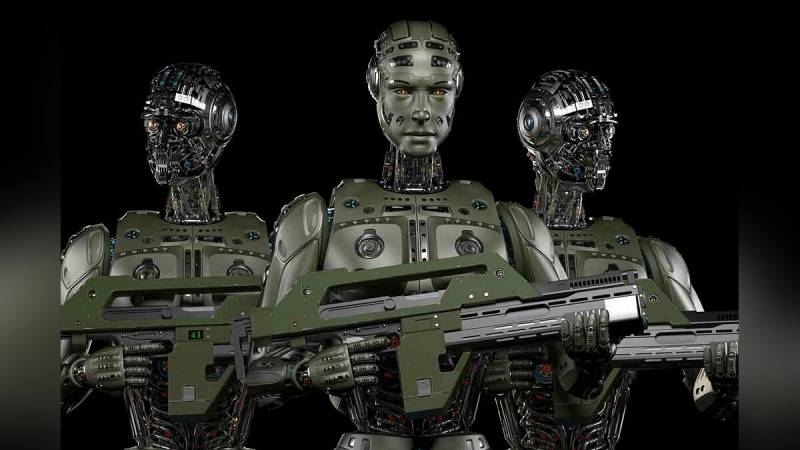

Notas de la mente humana: los estadounidenses quieren cambiar la inteligencia artificial militar

Fuente: vgtimes.ru

¿Se cancela la deshumanización digital?

Primero, una palabra de advertencia de los combatientes militares de la IA:

Los pacifistas que exigen congelar todo el trabajo sobre inteligencia artificial de combate se dividen en dos tipos. El primero son los "Terminators" revisados y otros análogos. El segundo: evaluar el futuro de acuerdo con las capacidades modernas de los robots de combate. En primer lugar, vehículos alados no tripulados equipados con sistemas de ataque.

Ya hay bastantes episodios de destrucción errónea o deliberada de civiles por parte de drones. En el Medio Oriente, América Drones destruyó más de una ceremonia de boda. Los operadores de robots voladores identificaron el tiroteo aire-aire de celebración como un marcador de tiroteos guerrilleros. Si una persona especialmente entrenada no puede determinar los detalles del objetivo desde varios cientos de metros, entonces, ¿qué podemos decir sobre la inteligencia artificial? Por el momento, la visión artificial, en términos de adecuación de la percepción de imágenes, no se puede comparar con el ojo y el cerebro humanos. A no ser que se canse, pero esto también se soluciona con un cambio oportuno de operador.

Las nubes se están acumulando claramente sobre la inteligencia artificial militar. Por un lado, cada vez hay más evidencia de un avance tecnológico inminente en esta área. Por otro lado, cada vez se escuchan más voces a favor de limitar o incluso prohibir el trabajo en este sentido.

Algunos ejemplos.

En 2016 apareció una petición en la que destacados pensadores y miles de personas más exigían que la inteligencia artificial no se dotara de armas letales. Entre los firmantes se encuentran Stephen Hawking y Elon Musk. En los últimos siete años, la petición ha recogido más de 20 firmas. Además de los temores puramente humanistas asociados con la posibilidad de destrucción incontrolada de personas, también existen inconsistencias legales.

¿Quiénes serán juzgados en caso de fijar crímenes de guerra cometidos por inteligencia artificial? El operador de drones que incendió varias aldeas con civiles es fácil de encontrar y castigar en consecuencia. La inteligencia artificial es un producto del trabajo colectivo de los programadores. Es muy difícil atraer a una persona aquí. Alternativamente, puede juzgar a la empresa fabricante, por ejemplo, la misma Boston Dynamics, pero luego quién participará en la producción de drones autónomos. Pocas personas tendrán el deseo de estar en el banquillo del segundo Tribunal de Nuremberg.

Fuente: koreaportal.com

Probablemente sea por esta razón que los industriales y los programadores están tratando de ralentizar el desarrollo de las habilidades de combate de la inteligencia artificial.

Por ejemplo, en 2018, unas doscientas empresas de TI y casi cinco mil programadores se comprometieron a no trabajar en sistemas autónomos de combate. Google afirma que en cinco años abandonará por completo los contratos militares en el campo de la inteligencia artificial. Según la leyenda, tal pacifismo no es accidental: los programadores, al enterarse de que estaban escribiendo códigos para sistemas militares, amenazaron con renunciar en masa. Como resultado, encontraron una opción amistosa: los contratos existentes se completan, pero no se concluyen nuevos. Es posible que más cerca de la fecha de la negativa a trabajar en la IA de combate, los "programadores" intratables simplemente sean despedidos, reemplazándolos por otros no menos talentosos. Por ejemplo, de la India, que durante mucho tiempo ha sido famosa por sus recursos intelectuales baratos.

Luego está la oficina de Stop Killer Robots, que pide a los líderes mundiales que firmen algo así como una convención para prohibir la IA de combate. Hasta ahora sin éxito.

Todo lo anterior hace que los oficiales militares busquen soluciones alternativas. Ni siquiera una hora en las elecciones ganará el presidente de los EE. UU., Prometiendo no solo la gracia LGBT universal, sino también la prohibición de mejorar la inteligencia artificial militar.

Pensamiento humano para IA

El Pentágono parece estar en la cúspide de algún tipo de avance en IA. O estaba convencido de ello. No hay otra manera de explicar la aparición de una nueva directiva que regula la humanización de los sistemas de combate autónomos. Kathleen Hicks, subsecretaria de Defensa de EE. UU., comenta:

¿Has escuchado a todos los que están asombrados por los robots asesinos autónomos? La inteligencia artificial americana será en adelante la más humana. Al igual que los propios estadounidenses.

Fuente: robroy.ru

El problema es que nadie entiende realmente cómo inculcar en los robots con armas el notorio "juicio humano sobre el uso de la fuerza". La redacción exacta del Concepto actualizado a fines de enero pasado:

Aquí, por ejemplo, si, al limpiar una casa, un avión de ataque primero arroja una granada a la habitación y luego ingresa. ¿Es esto un juicio humano? Por supuesto, y nadie tiene derecho a juzgarlo, sobre todo si previamente gritó “¿Hay alguien?”. ¿Y si un robot autónomo funciona según el mismo esquema?

El juicio humano es un concepto demasiado amplio para ser limitado de alguna manera. ¿La ejecución de prisioneros de guerra rusos por combatientes de las Fuerzas Armadas de Ucrania también es un pensamiento humano?

La adición a la Directiva del Pentágono 3000.09 sobre sistemas de combate autónomos está llena de lugares comunes. Por ejemplo,

Antes de eso, al parecer, trabajaban con imprudencia y en contra de las leyes de la guerra.

Al mismo tiempo, no hay una pizca de crítica a la iniciativa de enero del Pentágono en la prensa estadounidense y europea. Bajo la falsa humanización de la inteligencia artificial no hay más que un intento de disfrazar lo que está pasando. Ahora, el ejército de los EE. UU. tendrá una sólida carta de triunfo en la lucha contra los oponentes de la inteligencia artificial en el ejército. Mire, no tenemos una IA simple, sino con "el nivel correcto de juicio humano".

Teniendo en cuenta que aún no existe una definición clara y generalmente aceptada de "inteligencia artificial", toda la creación de letras a su alrededor se percibe con ironía. Al menos.

¿Cómo hacer que los algoritmos matemáticos que trabajan con grandes matrices de datos reproduzcan juicios humanos?

Esta pregunta principal no se responde en la Directiva 3000.09 actualizada.

información